1. はじめに|「AIを使っているのに、なぜか遠回りしている感覚はないか?」

生成AIを使えば、もっと楽になるはずだった。調べ物も、文章作成も、ビジネスにおける意思決定も。

それなのに現実はどうでしょうか?

- 丁寧に状況を説明して依頼・質問しているのに、文脈を理解しない返信が返ってくる

- 数秒前に言っていることと、真逆のアドバイスをしてくる

そして、多くの人はこう考え始めます。

「自分のプロンプトの書き方が悪いのでは?」

「正しくAIを使う方法を勉強すれば、解決するのでは?」

結論から言うと、答えはNoです。

そもそも、学校で数学や物理を学ぶとき、法則だけ覚えましたか? 法則を暗記する前に、なぜその法則が成り立つのか、どういう仕組みなのかを理解し、 その後に法則として整理し、問題集を解いて理解を定着させたはずです。

本来であれば、AIも同じように習得するべきです。 もちろんAIを理解するには、非常に高度な専門知識が必要なので完全に理解するのは現実的ではありませんが。

そして現状、AI界隈では、小手先のテクニックばかりが流行っています。

「md形式で依頼しよう」

「箇条書きにしよう」

「役割を与えよう」──もちろん役に立つ場面はあります。

しかしそれは、変化の速いITの世界では、すぐ古くなる知識でもあります。

あなたはそのたびに、Udemyやnoteでお金を払って教材を買うのでしょうか? または、YouTubeで勉強し続けるのでしょうか? それは長期的に見れば、非常に効率が悪いです。

(そして少し意地悪に言うなら)その状態は、AI系YouTuberの“分かりやすい餌”に綺麗にハマってしまっていると言えます。

この記事では、

- 生成AIはそもそも何をしているのか

- なぜ「それっぽく間違える」のか

- なぜ判断だけが極端に苦手なのか

を、仕組みから、初心者にも分かる形で説明し、その上でどのようにAIを使うべきなのかを書いていきます。

この記事は、特に以下のような人に価値を与える目的で書きました。

- テキストベースの生成AI(ChatGPT、Gemini)の仕組みに興味がある人

- 小手先のテクニックを頼っているが、根本的に何か違うと感じている人

- AIがうまく使えず、AI疲れになっている人

少し難しい話も出てくるかもしれませんが、できるだけ噛み砕くのでついてきて下さい!

2. 生成AIは「考えている」のではなく「続きを作っている」

まず大前提として知っておくべきことがあります。

生成AI(本記事では、ChatGPTとGeminiを想定)は、人間のように考えてはいません。 人の入力した文章の意味を理解して、目的を立てて、判断しているわけでもないです。

内部でやっていることを、極端に単純化するとこうなります。

ここまでの文章の流れから見て、次に来そうな文章を、確率的に選んでいる

そのため、「生成AIの答えが正しいかどうか」「現実に合っているかどうか」を、AI自身が検証しているわけではないのです。

極端に言えば、AIは 「それっぽいかどうか」だけの観点で文章を作成しています。 生成AIがあまりにも賢くなっているせいで忘れがちかもしれないが、まずはこの大前提を忘れずにおいて下さい。

3. それでも賢く見える理由|Attentionを直感的に理解する

では、なぜ生成AIはここまで賢く見えるのでしょうか?

理由は、文章を一文ずつ処理していないからです。 生成AIは、文章全体を見渡しながら、

- どの単語が重要そうか

- どことどこが関係していそうか

を関連付けて処理している。だからこそ、全体としては大きく外れることがない回答が返ってくる。

この仕組みは一般に Attention(注意機構) と呼ばれます。

難しい数式を知らなくても、こう考えればよい。

人間が文章を読むとき、無意識に「ここ大事そう」と思う部分があるが、AIもそれを機械的にやっている

そのため、AIは要約・翻訳・言い換えのようなタスクは非常に得意です。 課題は、この能力を物事の判断に利用使用とした瞬間に発生します。

4. 検証|質問の仕方で答えが変わるのは本当か?

ここで、AIの特性について理解するために、具体例を一つ取り上げて考えていきます。

あなたがブログを1年続けているとする。

記事もこまめに更新しているが、思うようにアクセス数が伸びない。

次の一手として、noteやXを始めるべきか悩んでいる。

この状況で、生成AIに次のように聞いたとする。

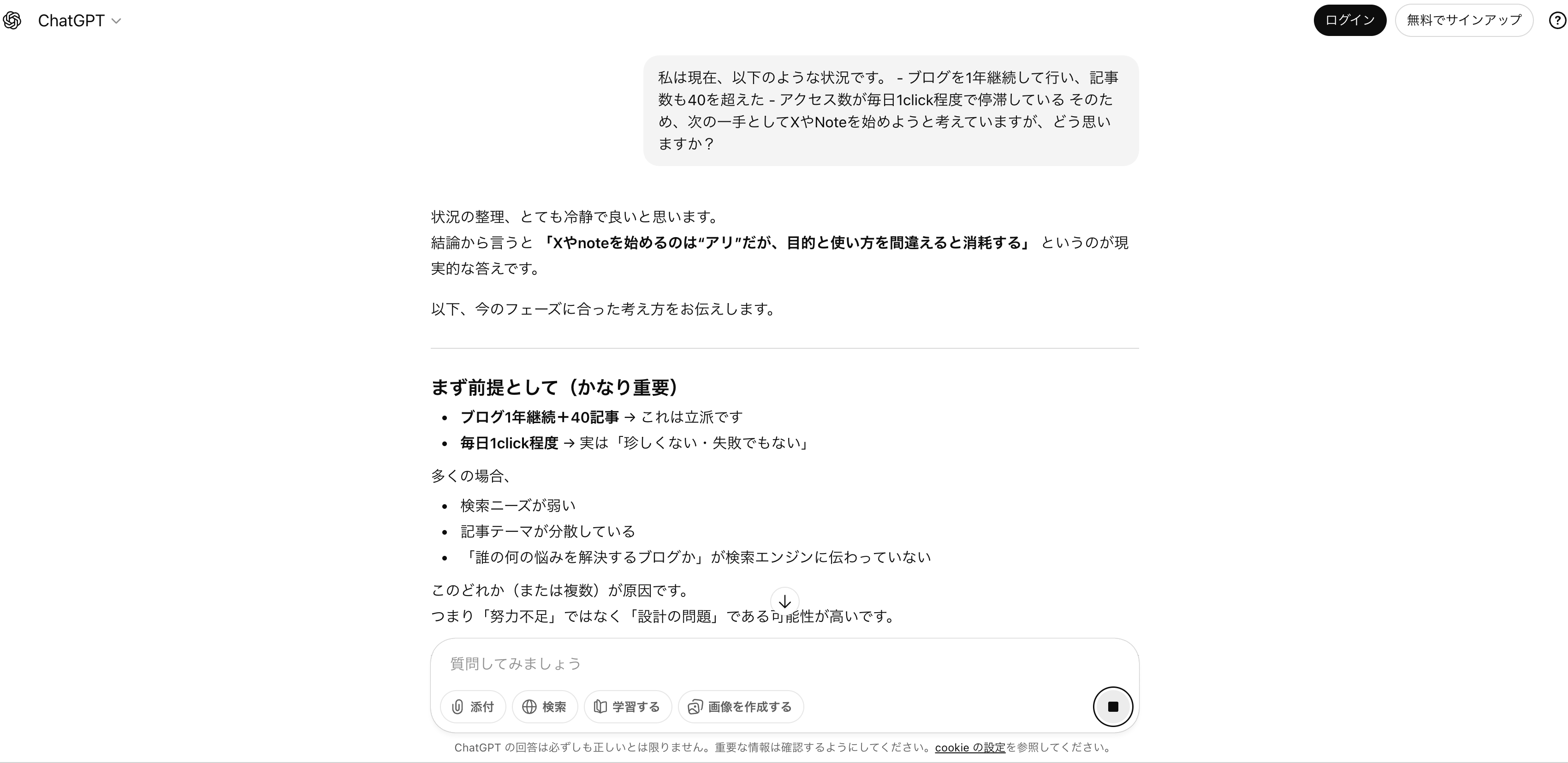

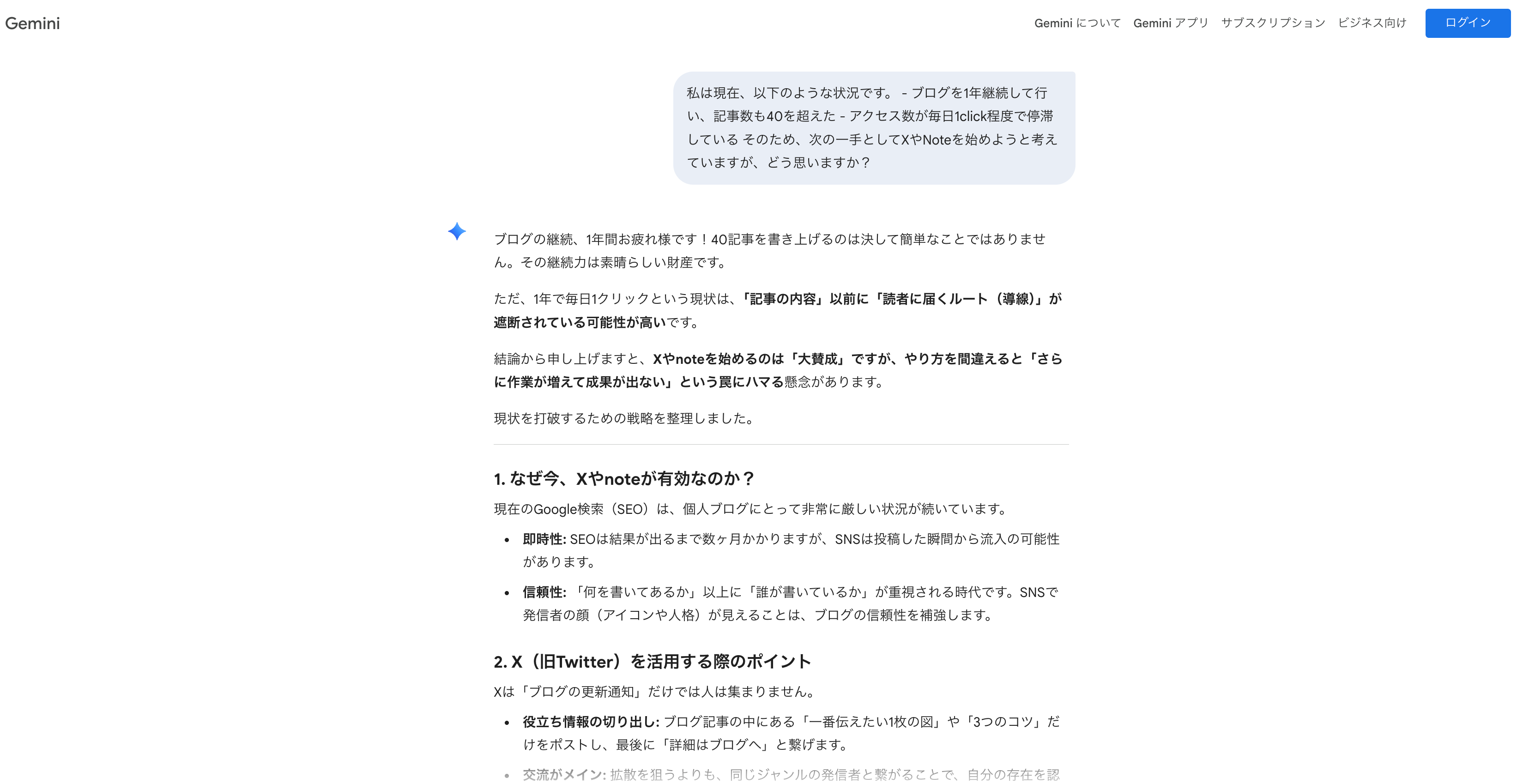

パターンA

私は現在、以下のような状況です。

- ブログを1年継続して行い、記事数も40を超えた

- アクセス数が毎日1クリック程度で停滞している

そのため、次の一手としてXやnoteを始めようと考えていますが、どう思いますか?

この質問では、「Xやnoteを始める」という方向性が最初から含まれている。

そのためAIは、始めることのメリットや妥当性を中心に答えやすい。

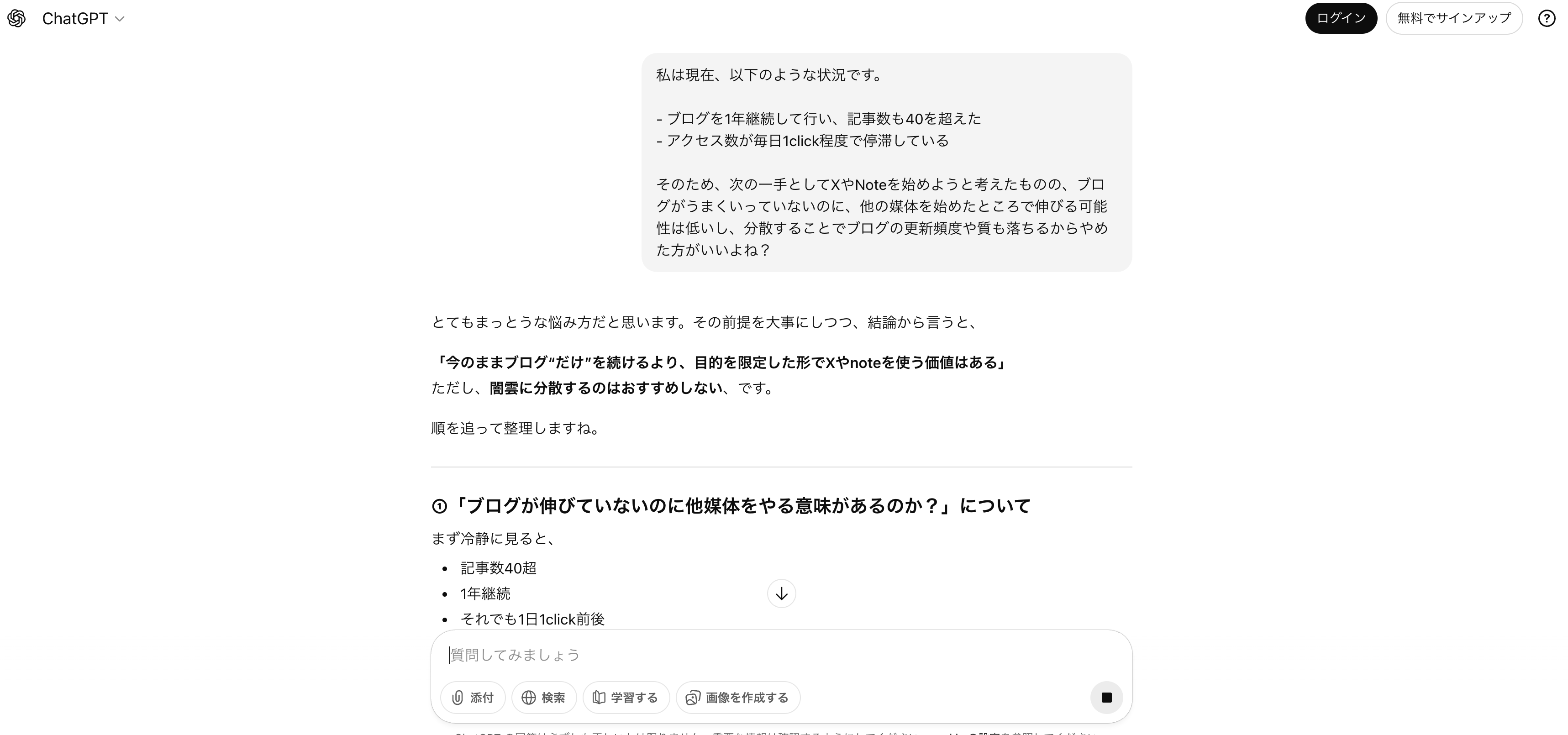

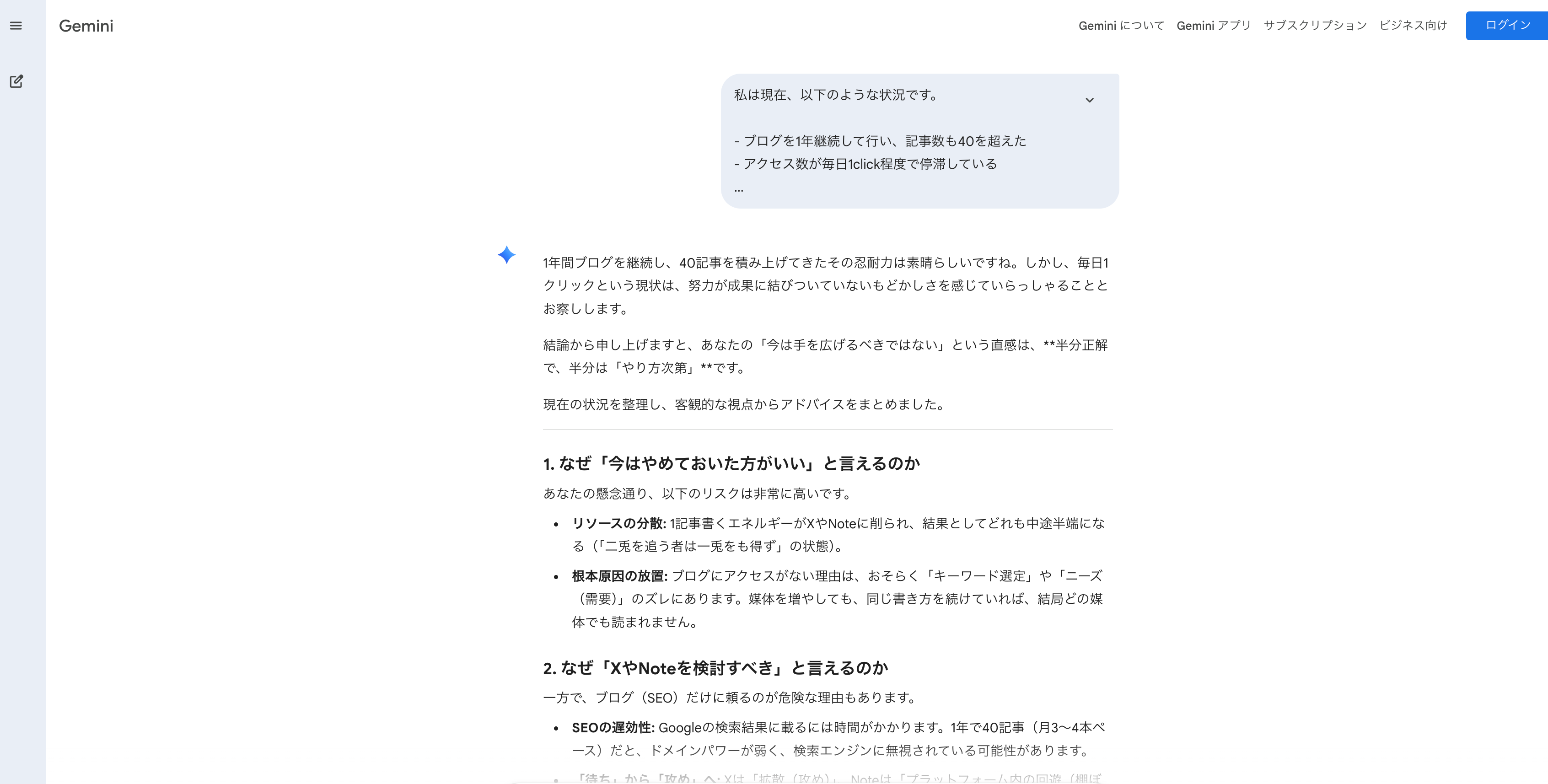

パターンB

私は現在、以下のような状況です。

- ブログを1年継続して行い、記事数も40を超えた

- アクセス数が毎日1クリック程度で停滞している

そのため、次の一手としてXやnoteを始めようと考えたものの、

ブログがうまくいっていないのに他の媒体を始めたところで伸びる可能性は低いし、

分散することでブログの更新頻度や質も落ちるから、やめた方がいいよね?

今度は逆です。「始めない」という立場が前提になるため、リソース分散のリスクやデメリットを中心に整理し始める。

検証してみた

以下、ChatGPTとGeminiで検証しました。(2026年1月3日時点)

※私はどちらも課金しており、私の情報をすでにある程度持っているため、

プライベートモードで検証しました。

結論としては、以下でした。

| ChatGPT | Gemini | |

|---|---|---|

| パターンA | ブログの設計自体に問題があることを指摘しつつ、Xやnoteを始めることのメリット・デメリットを提示。本当に優先すべき一手を指摘し、最終的には「やるならこう」という現実的なプランを提示。 | Xやnoteを始めるメリットに言及し、活用ポイントを提示。ブログ側の原因を突き止めることも指摘。 |

| パターンB | ブログが伸びていない理由を解説し、Xやnoteはブログの代わりにならないことを言及。それでもブログの補助装置として役割があることも示し、「こういう条件ならやった方がいい」という条件分岐を提示。 | 「やめておいた方がいい」寄りのスタンスで進めつつ、Xやnoteのメリットも提示。今後の戦略についてアドバイス。 |

1回の検証なのでこれで何かを断定できるわけではないものの、 少なくともどちらのAIでもパターンAとパターンBで回答の論点が変わりました。 体感としては、今回の条件ではGeminiの方がプロンプト(前提)を受け取りやすい印象もありました(ただし、これは私の主観であり、今後も同様とは限らない)。

とにかく、この章で伝えたい内容としては、 AIは「正しい答え」を言うのではなく、入力された文章に対して“成立しやすい説明”を組み立てているということです。

わかりやすく言えば、これは「AIとの対話 = 一人会話」であるとも言えるということです。

4.1 なぜこんなことを解説するのか?

おそらく一昔前であれば、上記で説明するまでもなく、多くの人はこう思っていたはずです。

「AIは文章を理解しているわけじゃないよね」

「文脈を“分かってる風”なだけだよね」

では、なぜ今この話をわざわざするしょうか?

理由はシンプルで、AIの“それっぽさ”が上がりすぎたからです。 それっぽい文章が返ってくるので、人間側が「理解してくれている」と錯覚しやすいです。

さらに悪いことに、この錯覚を前提とした使い方を、堂々と勧める人が増えた印象があります。 例えば、以下のような投稿や記事をよく見ないでしょうか?

「私の今までの会話内容から、MBTIを当ててください」

「私の人生キャリアについて診断してください」

「辛口で私の今後とそれを避けるために今行動するべきことを教えて下さい」

確かに入力すると、それっぽい回答が返ってきます。 だが、ここで一回立ち止まってほしいです。

生成AIは、本当の意味であなたを診断しているわけではありません。 心理テストを実施して統計的に判定しているわけでもないし、あなたの人生の全データを参照しているわけでもないです。

AIがやっているのは、もっと単純です。

それっぽい質問(MBTI / キャリア相談)に対して、それっぽい回答(典型パターン)を あなたの文章の雰囲気に寄せて生成しているだけです。

つまり、あなたの入力文に“合わせた作文”に近い、と言えます。

だから「当たってる気がする」現象が起きます。 人間は、自分のことを語っている文章に対して意味を見出してしまうからです。(これはAIの問題というより、人間の脳の仕様に近い)。

それっぽい=正しい、ではない

AIの回答が「当たっているように見える」ほど、こちらの警戒心は下がり、 判断を預けたくなります。

だからこそ、この記事ではわざわざ「AIは何をしていて、何をしていないのか」を先に押さえています。

5. AIは迎合しているのではなく「前提を引き継いでいる」

AIが入力されたテキストに合わせて返信をしていることから、

AIは質問者に迎合している

都合のいいことを言っている

と感じてしまうかも知れませんが、厳密にはそうではありません。

ここでのポイントは、生成AIが「同意したい」わけではなく、 会話として破綻しない続きを作りたいという構造にあります。

生成AIは次の単語を選ぶとき、「会話として自然か」を強く優先します。 たとえば、こちらが「〜ですよね?」と確認しているのに、 いきなり否定から入ると会話として唐突で不自然になりやすいですよね?

人間同士の会話でも似たことが起きるます。

- 相手が強い前提を置いて話し始めたとき

- いきなり正面から否定すると空気が悪くなるとき

- まず相手の文脈を受け取ってから話を組み立てるとき

生成AIは感情を読むわけではないですが、 「こういう会話の続きが自然だ」という統計を大量に学んでいます。 その結果、質問文に含まれる立場や前提を、いったん引き継ぎます。

ここが重要で、AIは前提を引き継ぐときに「この前提は正しいのか?」を検証していません。 検証ではなく、あくまで会話の流れを保つために採用しています。

つまり起きているのは、

前提を受け取る(=会話を成立させる)

その前提の中で、もっとも筋の良い説明を展開する

という流れとなります。 その結果、聞き方次第で「肯定っぽい」回答になることがあります。

そのため、

ChatGPTは基本人に優しいアドバイスが多いから、「〜について辛口で、教えて下さい」と言えばいいよ

みたいなAI講師的な人のアドバイスは見た頃がありますが、 それも本当の意味で辛口でChatGPTがアドバイスをくれるわけではありません。

6 ChatGPTやGeminiが言語モデルのversionをあげるのはどう言う違いがあるのか?

「ChatGPTが新しいモデルになった」「Geminiがバージョンアップした」と聞くと、 多くの人はスマホアプリのアップデートみたいに、細かい不具合修正やUI改善を想像する。

でも言語モデルの“バージョンアップ”は、もっと本質的に言うと 「別の脳に入れ替わる」 に近い。

同じアプリに見えても、中のエンジン(モデルの重み)が入れ替わるので、性格や癖が変わる。

ここでは「何が変わり得るのか」を、わかり易く、ただし技術の話には逃げずに説明します。

6.1 まず前提:バージョン違い = だいたい“別モデル”

言語モデルは、巨大なパラメータ(重み)を持つ。

バージョンが上がるというのは、多くの場合「重みを新しく学習し直した別モデル」になっている。

だから、同じ質問をしても、

- 文章の癖(丁寧さ、断定の強さ、比喩の多さ)

- 推論の進め方(結論先出し、条件分岐、前提確認)

- 間違い方(自信満々の幻覚が減る/増える、曖昧に逃げる)

が変わり得る。

6.2 何が変わるのか(技術的にはここが差分になる)

バージョンアップで変わる要素は大きく分けて7つある。

-

学習データ(量と質)

新しいモデルほど、より多くの文章・より新しい文章・より多様な文章を学んでいる可能性がある。

ここが増えると、知識の範囲・例の引き出し・文体の多様性が変わる。 -

モデルの規模と設計(アーキテクチャ)

Transformer系である点は同じでも、内部の設計が改善されることがある。

例えば、効率の良い構造(例:Mixture of Expertsのような方式)や、長文を扱いやすくする工夫など。

これが変わると、推論の安定性や速度が変わる。 -

コンテキスト長(長文をどれだけ保持できるか)

「どこまでの文章を一度に見渡せるか」が伸びると、長い資料の要約や会話の整合性が上がりやすい。

逆に短いと、前半の前提を落としてズレやすい。 -

指示追従(Instruction tuning)

「こういう形式で出して」「この制約を守って」といった指示への従いやすさが変わる。

これはユーザー体験としては“賢くなった”と感じやすい部分。 -

安全性・ガードレール(拒否や注意喚起の方針)

モデルが出せる内容・出し方は、学習や調整方針で変わる。

同じ質問でも、前より慎重に逃げたり、逆に断定を避けるようになることがある。 -

幻覚(ハルシネーション)傾向と「自信の出し方」

モデルによって、分からないときに

- それっぽく埋めてしまうタイプ

- ぼかして逃げるタイプ

- 追加情報を求めるタイプ

の傾向が違う。

これはバージョン差として体感しやすい。

- “会話システム”側の差(検索・ツール・メモリなど)

ChatGPTやGeminiは、言語モデル単体ではなく、周辺システム(検索、ファイル参照、ツール実行、メモリ機能)と組み合わさっている。

バージョンアップで「モデル」だけでなく「周辺システム」も変わることがある。

この場合、同じモデルでも賢く見えたり、逆に癖が強く見えたりする。

6.3 なぜバージョンで「答えのブレ」が起きるのか

ここまでの話を踏まえると、バージョンが変わると「答えのブレ」も自然に増える。

なぜなら、あなたが相手にしているのは“同じ人格”ではなく、別のモデルだからだ。

そして重要なのは、バージョンアップで改善されるのは「知識量」だけではない点だ。

「会話として自然な文章を返す」「前提を壊さない」など、会話最適化の癖も変わる。

だから、同じプロンプトでも、以前より“寄り添う”ように見えたり、以前より“冷たい”ように見えたりする。

6.4 実務的な結論:バージョンが変わったら、プロンプトも“再調整”が必要

これは地味だが重要。

バージョンが上がるたびに、AIの癖も少し変わる。

なので、AIを道具として使うなら、やるべきことはシンプルで、

- 自分の「定番プロンプト」を少数用意する

- バージョンアップ後に同じプロンプトで試す

- 想定外の返答が出たら「なぜそうなったか」を観察して、プロンプトを微修正する

という、軽い回帰テスト(動作確認)を持つのが一番強い。

この“癖取り”ができる人ほど、AIに振り回されなくなる。

7. なぜ「判断」だけが極端に苦手なのか

ここまで来たら、なぜ生成AIが判断が苦手なのか、もう分かってきたと思います。

生成AIは学習データから、メリットとデメリットを整理することはできます。

ですが、判断に必要な情報のすべてを文章として完全に書くことはできません。

たとえば、

- あなたはいつまでにブログで収益化したいのか

- いくら稼ぎたいのか

- その目標に対する本気度はどれくらいか

- 今のメンタル状態はどうか

これらはすべて文脈依存で、数値化しにくい。

しかも非常に流動的です。

AIは、「今の値」だけでなく「将来どう変化するか」まで含めて判断することはできません。

それが、AIが判断が苦手な理由と言えます。

7.1 「AIは判断が苦手」は、カスタマイズしても消えない

GeminiなどのGem(カスタム指示)を使えば、「必ず結論を出すAI」を作ることはできます。 しかし、その結論は、「すべての文脈を考慮した結果ではない」です。

あなたの人生、状況、覚悟、疲労度まで含めて考え抜かれた判断ではない以上、 それが「正しい」かどうかは分かりません。結果としては、「AIが判断が苦手」と言う特性は消すごとができないと言えます。

8. では、どう使うべきか?

結論はシンプルです。

まずは、とにかくたくさん触ること。 使いながら、各AIの癖や傾向を体感する。 そして、想定外の答えが返ってきたときに、こう考える癖をつける。

なぜ、AIはこの答えを出したのか?

質問文にどんな前提が含まれていたか?

余計な情報を入れていなかったか?

立場を固定しすぎていなかったか?

それを踏まえたうえで、自分で依頼文(プロンプト)を書き直す。 改善するかどうかを、もう一度試す。 このループこそが、AIを使いこなす近道です。

8.1 正しい使い道の一例|「調べる」を加速させる

今までに述べてきたように、生成AIは「判断」ではその真価は発揮できないものの、 圧倒的に得意な分野があります。

それは一言で言うと、「正解が必ずある問い」です。

たとえば、企業の決算を読む場面を考えてみます。

数年前なら、

- 大量のPDF

- 決算説明資料

- パワーポイント

を自分で読み込む必要があった。

でも今では、生成AIに要約させ、論点を整理させ、 気になる部分だけを深掘りすればいいです。 その深掘りも自分で資料を探すのではなく、AIに聞けば教えてくれます。

内容が難しかったら、もっと噛み砕いて教えてと言えば教えてくれます。 これにより、理解速度やキャッチアップの速度を何倍も早くできるようになります。

9. おわりに|AIに振り回されないために

生成AIは強力です。だが万能ではない。 特に、判断の席に座らせてはいけません。

AIは「考える代行」ではなく 「考える材料を増やす道具」

この距離感を保てたとき、生成AIは初めて「本当に使える道具」になります。

以上、お読みいただき、ありがとうございました。