ブログやアフィリエイトで稼ぐ仕組みを作ろうと考えたとき、 「プログラムで大量に記事を自動生成できれば最強なのでは?」と妄想する人は多いのではないでしょうか。

これは「プログラマティックSEO(pSEO)」として確立されており、Tripadvisorや食べログなども活用している強力な手法です。

私自身もその誘惑に駆られ、Pythonを使って「地域名+水道修理」の組み合わせで一気に2000ページを生成し、不労所得のシステムを構築しようと目論みました。

結論から言うと、見事に大爆死しました。

この記事では、Google Search Consoleに突きつけられた「インデックス未登録1894件」という残酷な現実と、そこから学んだ現代SEOの厳しさ、そして傷口を塞ぐために行った「Pythonによる大手術」の全記録を赤裸々に公開します。

1. 夢のプログラマティックSEOと、2000ページ一括デプロイの罠

今回私は、以下の構成でシステムを組み上げました。

- データソース: 全国の市区町村リスト(CSV)

- テンプレート: 水道修理のアフィリエイトリンクを配置したHTMLベースの記事

- デプロイ: Pythonの

requestsライブラリからWordPress REST APIを叩き、変数を差し替えながらループ処理で一括Post

「これで数週間放置すれば、全国のロングテールキーワードを拾ってチャリンチャリンと稼げるはず…!」 そう半信半疑の状態で、日曜日の夜に作業を完了しました。

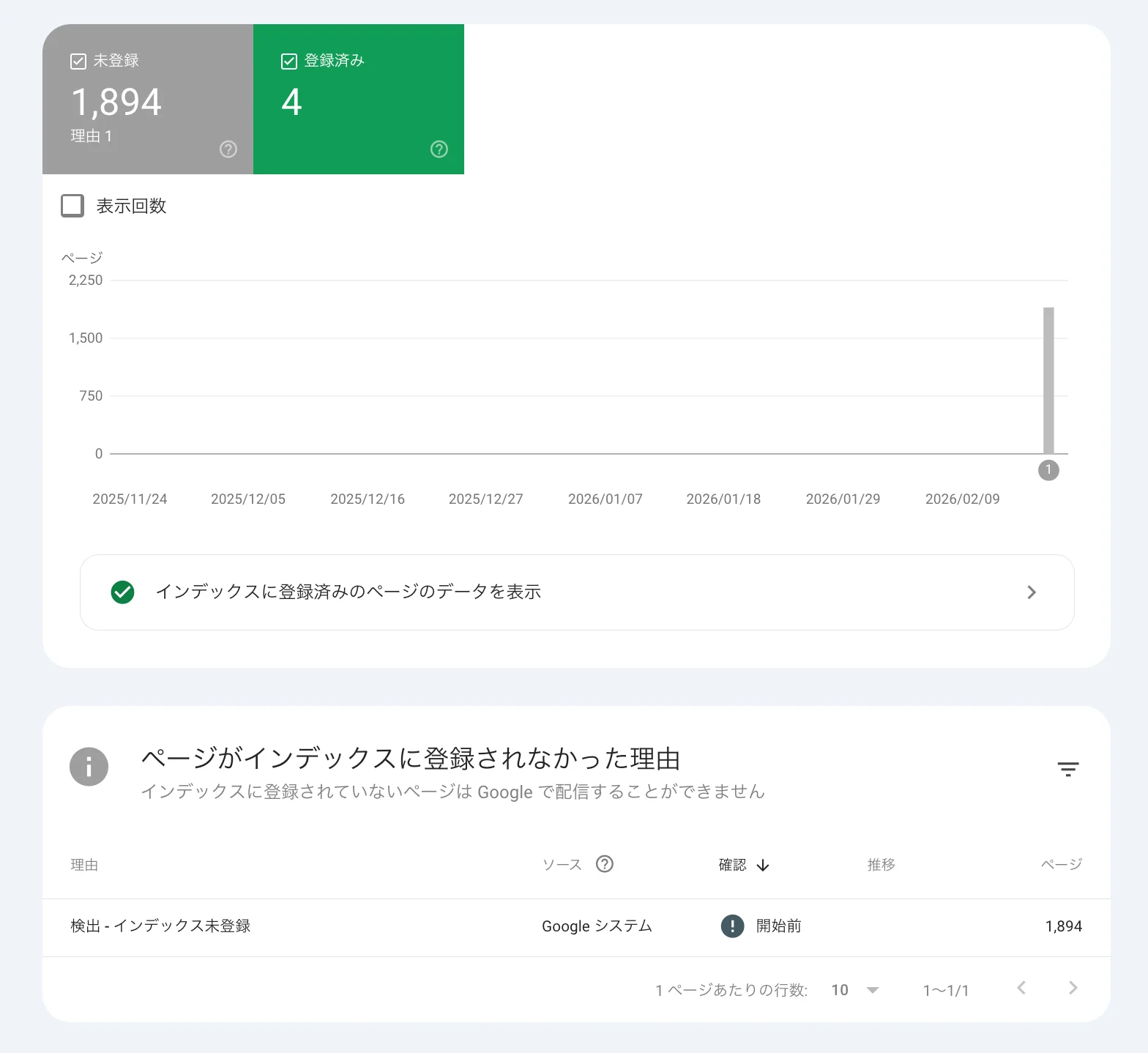

2. 絶望のサチコ画面。「検出 - インデックス未登録」1894件の衝撃

デプロイから1週間後。意気揚々とGoogle Search Consoleを開いた私の目に飛び込んできたのは、無慈悲な数字でした。

「検出 - インデックス未登録:1,894件」

SEOにおいて、これは実質的な死刑宣告です。「GoogleのクローラーがURLの存在は認識したけれど、わざわざ読み込んでインデックスする価値がない(品質要件を満たしていない)から放置しているよ」という状態を指します。 2000件のうち、奇跡的にインデックスされたのはトップページなどごくわずかでした。

3. なぜ弾かれた?SIer的視点で敗因を分析

安くないインフラ費用を払って得た「1894件の未登録」というデータから、いまの検索エンジンの残酷な現実が見えてきました。 敗因は明確に2つあります。

① 変数を差し替えただけの「テンプレ使い回し」は即死する

一昔前は「{地域名}のトイレつまり修理!」のように、変数だけを差し替えた量産ページでも検索上位に上がる時代がありました。 しかし現在のGoogle(特にヘルプフルコンテンツシステム導入後)において、これは 「情報利得(Information Gain)のない重複コンテンツ」としてスパム扱いされます。立ち上げたばかりのドメインで一気に2000ページも生成したことで、クロールバジェット(Googleがサイトを巡回する上限枠)を無駄遣いし、警戒度を跳ね上げてしまいました。

② ページごとの「独自性(差分)」が皆無

検索エンジンが求めているのは、「その地域ならではの固有情報」です。 単なるテキストの差し替えではなく、地域の指定水道局リストや、独自の統計データなどが組み込まれていない限り、ただの「薄っぺらいページの量産」と見なされて弾かれます。

4. サーバー代1年分払ったので、執念の「大手術」を実行

「完全に失敗だった」と損切りするのもアリですが、せっかくインフラ費用を払ったので、最後に実験的な「大手術」を行うことにしました。 手作業で直す気は毛頭ないので、再度Pythonを回します。

STEP1: 勇気の大量削除(noindex化)

1900件近い低品質ページがドメイン全体の評価を下げているため、Pythonで一括してステータスを「公開」から「下書き」へ落としました。

STEP2: 主要都市を捨て、「地方・衛星都市50選」に絞る

ここが戦略の肝です。 東京23区や大阪市などの主要都市は、強力なドメインパワーを持つ大手企業やポータルサイトが上位を独占しており、新規サイトでは絶対に勝てません。 そこでレッドオーシャンは潔く諦め、需要はあるが競合が弱い「人口5万〜15万人の地方都市(Tier2〜Tier3)」50ページのみを残しました。主要都市ほど大手優遇が顕著なため、この方針転換は必須でした。

STEP3: APIで独自データ(ローカル情報)を動的追記

残した50ページに対し、{地域名} 水道局 で検索したGoogle MapsのiframeタグなどをPythonで自動生成し、記事へ一括追記しました。

これで、「薄っぺらい2000ページの量産サイト」から、「競合の少ない地方に特化し、ローカル情報を付与した50ページ」へと生まれ変わりました。

まとめ:自動化は魔法じゃない。価値のレバレッジだ

今回のプログラマティックSEOへの挑戦を通じて、まあシステム化は難しいとは感じたものの、 最初の設計が非常に肝心になってくるなと感じました。

自動化の本質は、すでにある「独自の価値(データ)」をレバレッジさせて拡張することです。 小手先のハックで検索エンジンを騙せる時代は、とうの昔に終わっていたのでしょう。

安くない勉強代にはなりましたが、この「失敗の一次情報」こそが最高の資産だと思っています。 この件について、進展があればまたまとめてみようと思います。